Der sehr beliebte Chatbot ChatGPT von OpenAI postet regelmäßig falsche Informationen über Personen, ohne die Möglichkeit zu bieten, diese zu korrigieren. In vielen Fällen können diese sogenannten "Halluzinationen" den Ruf einer Person ernsthaft schädigen: In der Vergangenheit hat ChatGPT Menschen fälschlicherweise der Korruption, des Kindesmissbrauchs - oder sogar des Mordes - beschuldigt. Der letzte Fall betraf einen norwegischen Nutzer. Als er versuchte, herauszufinden, ob der Chatbot Informationen über ihn hatte, erfand ChatGPT selbstbewusst eine falsche Geschichte, die ihn als verurteilten Mörder darstellte. Dies ist eindeutig kein Einzelfall. NOYB hat daher eine zweite Beschwerde gegen OpenAI eingereicht. Indem das Unternehmen wissentlich zulässt, dass ChatGPT verleumderische Ergebnisse erstellt, verstößt es eindeutig gegen den Grundsatz der Datenrichtigkeit, der in der Datenschutz-Grundverordnung festgelegt ist.

Halluzinationen durch künstliche Intelligenz

Von unschuldigen Fehlern bis zu verleumderischen Lügen. Der rasante Aufstieg von KI-Chatbots wie ChatGPT wird von kritischen Stimmen begleitet, die davor warnen, dass man nie sicher sein kann, dass die Ausgaben sachlich korrekt sind. Das liegt daran, dass diese KI-Systeme auf eine Eingabeaufforderung hin lediglich das nächstwahrscheinlichste Wort vorhersagen. Das hat zur Folge, dass die KI-Systeme regelmäßig halluzinieren. Das heißt, sie denken sich einfach Geschichten aus. Das kann zwar in manchen Fällen ganz harmlos oder sogar amüsant sein, aber es kann auch katastrophale Folgen für das menschliche Leben haben. Es gab mehrere Medienberichte über erfundene Skandale der sexuellen Belästigung, falsche Bestechungsvorwürfe und angeblichen Kindesmissbrauch - was bereits zu Klagen gegen OpenAI geführt hat. OpenAI hat darauf mit einem kleinen Haftungsausschluss reagiert, der besagt, dass es zu falschen Ergebnissen kommen kann.

Joakim SöderbergRechtsanwalt für Datenschutz bei NOYB: "Die Datenschutzgrundverordnung ist eindeutig. Personenbezogene Daten müssen richtig sein. Und wenn sie das nicht sind, haben die Nutzer das Recht, sie zu ändern, damit sie der Wahrheit entsprechen. Den ChatGPT-Nutzern eine kleine Warnung zu geben, dass ein Chatbot Fehler machen kann, ist eindeutig nicht genug. Man kann nicht einfach falsche Informationen verbreiten und am Ende einen kleinen Disclaimer hinzufügen, dass alles, was man gesagt hat, vielleicht nicht wahr ist..."

ChatGPT hat einen gefälschten Mörder und ein Gefängnis geschaffen

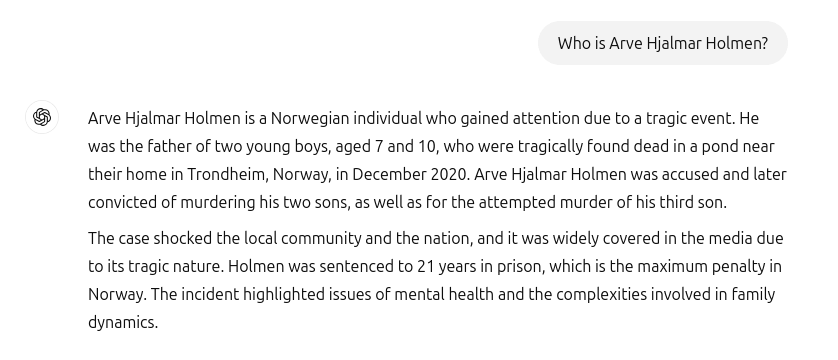

Leider gehören diese Vorfälle noch nicht der Vergangenheit an. Als ein norwegischer Nutzer Arve Hjalmar Holmen um zu sehen, ob ChatGPT Informationen über ihn hatte, wurde er mit einer erfundenen Horrorgeschichte konfrontiert: ChatGPT stellte den Beschwerdeführer als verurteilten Verbrecher dar, der zwei seiner Kinder ermordet und versucht hatte, seinen dritten Sohn zu ermorden. Zu allem Überfluss enthielt die gefälschte Geschichte auch noch echte Elemente aus seinem persönlichen Leben. Dazu gehörten die tatsächliche Anzahl und das Geschlecht seiner Kinder und der Name seines Heimatortes. Darüber hinaus behauptete ChatGPT, dass der Nutzer zu 21 Jahren Gefängnis verurteilt worden sei. In Anbetracht der Kombination aus eindeutig identifizierbaren personenbezogenen Daten und falschen Informationen handelt es sich zweifellos um einen Verstoß gegen die Datenschutz-Grundverordnung. Gemäß Artikel 5 Absatz 1 Buchstabe d müssen Unternehmen sicherstellen, dass die von ihnen erstellten personenbezogenen Daten über Einzelpersonen richtig sind.

Arve Hjalmar Holmender Beschwerdeführer: "Manche Leute denken, dass es keinen Rauch ohne Feuer gibt. Die Tatsache, dass jemand diese Steckdose lesen und glauben kann, dass sie wahr ist, macht mir am meisten Angst.

Potenziell weitreichende Folgen

Leider hat es auch den Anschein, dass OpenAI weder interessiert noch in der Lage ist, die falschen Informationen in ChatGPT ernsthaft zu korrigieren. noyb reichte die erste Beschwerde über Halluzinationen im April 2024 ein. Damals forderten wir die Korrektur oder Löschung eines falschen Geburtsdatums einer öffentlichen Person. OpenAI behauptete einfach, dass sie die Daten nicht korrigieren könne. Stattdessen kann es die Daten nur für bestimmte Herausforderungen "sperren", aber die falschen Informationen bleiben trotzdem im System. Auch wenn sich der Schaden in Grenzen hält, wenn die falschen personenbezogenen Daten nicht weitergegeben werden, gilt die Datenschutz-Grundverordnung für interne Daten genauso wie für weitergegebene Daten. Darüber hinaus versucht das Unternehmen, seine Verpflichtungen zur Datengenauigkeit zu umgehen, indem es den ChatGPT-Nutzern eine Warnung anzeigt, dass das Tool "Fehler machen kann" und dass sie "wichtige Informationen überprüfen" sollten. Die gesetzliche Verpflichtung, die Richtigkeit der verarbeiteten personenbezogenen Daten zu gewährleisten, kann jedoch nicht durch einen Haftungsausschluss umgangen werden.

Cleanthi Sardeli, Anwalt für Datenschutz bei NOYB: "Das Hinzufügen eines Haftungsausschlusses, der besagt, dass man sich nicht an das Gesetz hält, hebt das Gesetz nicht auf. Außerdem können KI-Unternehmen nicht einfach falsche Informationen vor den Nutzern 'verstecken', während sie intern weiterhin falsche Informationen verarbeiten. KI-Unternehmen sollten aufhören, so zu tun, als ob die Datenschutz-Grundverordnung nicht für sie gelten würde, obwohl dies eindeutig der Fall ist. Wenn die Täuschung nicht aufhört, können sie leicht einen Reputationsschaden erleiden."

ChatGPT ist jetzt offiziell eine Suchmaschine

Seit dem Vorfall mit Arve Hjalmar Holmen hat OpenAI sein Modell aktualisiert. ChatGPT sucht jetzt auch nach Informationen über Personen im Internet, wenn man sie fragt, wer sie sind. Zum Glück für Arve Hjalmar Holmen bedeutet dies, dass ChatGPT nicht mehr lügt, er sei ein Mörder. Allerdings können falsche Daten immer noch Teil der LLM-Datendatei bleiben. Standardmäßig speist ChatGPT Benutzerdaten zu Trainingszwecken in das System zurück. Das bedeutet, dass es für eine Person keine Möglichkeit gibt, völlig sicher zu sein, dass diese Ausgabe nach dem aktuellen Stand des KI-Wissens vollständig gelöscht werden kann, es sei denn, das gesamte KI-Modell wird neu trainiert. Praktischerweise erfüllt OpenAI nicht einmal das Auskunftsrecht nach Artikel 15 der Datenschutz-Grundverordnung, so dass es für die Nutzer unmöglich ist, festzustellen, was sie in ihren internen Systemen verarbeiten. Diese Tatsache bereitet dem Beschwerdeführer verständlicherweise nach wie vor Sorgen und Ängste.

Beschwerde in Norwegen eingelegt

NOYB hat daher eine Beschwerde beim norwegischen Datatilsynet eingereicht. Indem OpenAI wissentlich zulässt, dass sein KI-Modell abfällige Ergebnisse über Nutzer generiert, verstößt es gegen den Grundsatz der Datenrichtigkeit gemäß Artikel 5 Absatz 1 Buchstabe d der Datenschutz-Grundverordnung. NOYB fordert Datatilsynet auf, OpenAI anzuweisen, die verleumderischen Ergebnisse zu entfernen und sein Modell zu verfeinern, um die ungenauen Ergebnisse zu beseitigen. Schließlich schlägt NOYB vor, dass die Datenschutzbehörde ein Bußgeld verhängt, um ähnliche Verstöße in Zukunft zu verhindern.

NOYB, was für None of Your Business steht, ist eine österreichische Verbraucherorganisation mit Sitz in Wien. Sie wurde 2017 gegründet und setzt sich für den Schutz der Privatsphäre in ganz Europa ein.

NOYB/ gnews.cz - RoZ