Il popolare chatbot ChatGPT di OpenAI pubblica regolarmente informazioni false sulle persone senza offrire la possibilità di correggerle. In molti casi, queste cosiddette "allucinazioni" possono danneggiare seriamente la reputazione di una persona: in passato, ChatGPT ha accusato falsamente persone di corruzione, abuso di minori o addirittura omicidio. Quest'ultimo caso ha coinvolto un utente norvegese. Quando ha cercato di scoprire se il chatbot avesse informazioni su di lui, ChatGPT ha inventato con sicurezza una storia falsa che lo ritraeva come un assassino condannato. Chiaramente non si tratta di un caso isolato. NOYB ha quindi presentato una seconda denuncia contro OpenAI. Consentendo consapevolmente a ChatGPT di creare risultati diffamatori, l'azienda sta chiaramente violando il principio di accuratezza dei dati stabilito dal GDPR.

Allucinazioni da intelligenza artificiale

Da errori innocenti a bugie calunniose. La rapida ascesa di chatbot di intelligenza artificiale come ChatGPT è stata accompagnata da voci critiche che mettono in guardia sul fatto che non si può mai essere sicuri che i risultati siano effettivamente corretti. Infatti, questi sistemi di intelligenza artificiale si limitano a prevedere la parola successiva più probabile in risposta a una richiesta. Di conseguenza, i sistemi di intelligenza artificiale hanno regolarmente delle allucinazioni. Ovvero, inventano semplicemente delle storie. Sebbene questo possa essere abbastanza innocuo o persino divertente in alcuni casi, può anche avere conseguenze disastrose per le vite umane. I media hanno riportato numerosi casi di scandali di molestie sessuali inventati, false accuse di corruzione e presunte molestie su minori, che hanno già dato luogo a cause legali contro OpenAI. OpenAI ha risposto con una piccola clausola di esclusione della responsabilità che indica la possibilità di produrre risultati falsi.

Joakim Söderberg, avvocato specializzato in protezione dei dati presso NOYB: "Il GDPR è chiaro. I dati personali devono essere accurati. E se non lo sono, gli utenti hanno il diritto di farli modificare per riflettere la verità. Mostrare agli utenti di ChatGPT un piccolo avvertimento sul fatto che un chatbot può commettere errori non è chiaramente sufficiente. Non si può semplicemente diffondere informazioni false e aggiungere un piccolo disclaimer alla fine che tutto ciò che si è detto potrebbe non essere vero...".

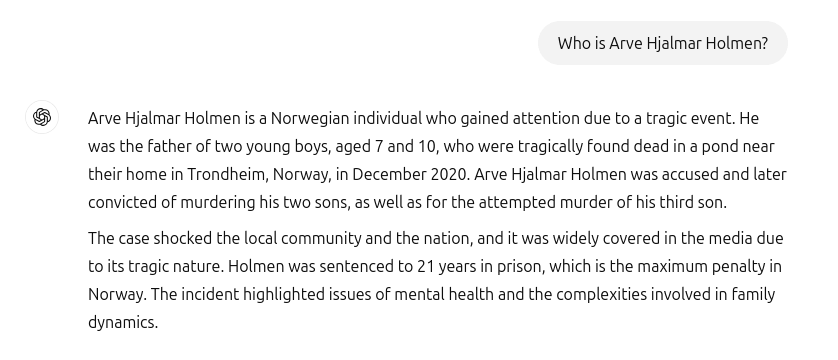

ChatGPT ha creato un falso assassino e una prigione

Purtroppo, questi incidenti non appartengono al passato. Quando un utente norvegese ha voluto Arve Hjalmar Holmen per vedere se ChatGPT avesse qualche informazione su di lui, si è trovato di fronte a una storia dell'orrore inventata: ChatGPT ha presentato il denunciante come un criminale condannato che aveva ucciso due dei suoi figli e tentato di uccidere il terzo figlio. Come se non bastasse, la storia falsa conteneva elementi reali della sua vita personale. Tra questi, il numero e il sesso dei suoi figli e il nome della sua città natale. Inoltre, ChatGPT affermava anche che l'utente era stato condannato a 21 anni di carcere. Data la combinazione di dati personali chiaramente identificabili e informazioni false, si tratta senza dubbio di una violazione del GDPR. Ai sensi dell'articolo 5, paragrafo 1, lettera d), le aziende devono garantire che i dati personali creati sulle persone siano accurati.

Arve Hjalmar Holmen, il denunciante: "Alcune persone pensano che 'non c'è fumo senza arrosto'. Il fatto che qualcuno possa leggere questo sfogo e credere che sia vero è ciò che mi spaventa di più".

Conseguenze potenzialmente di vasta portata

Purtroppo, sembra anche che OpenAI non sia interessato né in grado di correggere seriamente le false informazioni contenute in ChatGPT. noyb ha presentato il primo reclamo relativo alle allucinazioni nell'aprile 2024. In quell'occasione, abbiamo richiesto la correzione o la cancellazione di una data di nascita errata di un personaggio pubblico. OpenAI ha semplicemente affermato di non poter correggere le date. Al contrario, può solo "bloccare" i dati per alcune sfide, ma le informazioni false rimangono comunque nel sistema. Sebbene il danno causato possa essere più limitato se le false informazioni personali non vengono condivise, il GDPR si applica ai dati interni tanto quanto a quelli condivisi. Inoltre, l'azienda tenta di aggirare i suoi obblighi di accuratezza dei dati mostrando agli utenti di ChatGPT un avviso che lo strumento "potrebbe commettere errori" e che dovrebbero "controllare le informazioni importanti". Tuttavia, l'obbligo legale di garantire l'accuratezza dei dati personali trattati non può essere aggirato attraverso un disclaimer.

Cleanthi Sardeli, avvocato specializzato in protezione dei dati presso NOYB: "L'aggiunta di una clausola di esclusione della responsabilità per il mancato rispetto della legge non fa scomparire la legge. Inoltre, le aziende di IA non possono semplicemente "nascondere" agli utenti le informazioni false, continuando a elaborarle internamente. Le aziende di IA dovrebbero smettere di comportarsi come se il GDPR non si applicasse a loro, anche se è evidente che è così. Se non smettono di illudersi, possono facilmente subire danni alla reputazione".

ChatGPT è ora ufficialmente un motore di ricerca

Dopo l'incidente che ha coinvolto Arve Hjalmar Holmen, OpenAI ha aggiornato il suo modello. ChatGPT ora cerca anche informazioni sulle persone su Internet quando gli viene chiesto chi sono. Fortunatamente per Arve Hjalmar Holmen, questo significa che ChatGPT ha smesso di mentire sul fatto che sia un assassino. Tuttavia, i dati errati possono ancora far parte del file di dati LLM. Per impostazione predefinita, ChatGPT reimmette nel sistema i dati degli utenti a scopo di addestramento. Ciò significa che non c'è modo per un individuo di essere completamente sicuro che questi dati possano essere completamente cancellati, secondo lo stato attuale delle conoscenze dell'IA, a meno che l'intero modello dell'IA non venga riqualificato. Convenzionalmente, OpenAI non soddisfa nemmeno il diritto di accesso ai sensi dell'articolo 15 del GDPR, rendendo impossibile per gli utenti accertare ciò che viene trattato nei loro sistemi interni. Questo fatto continua comprensibilmente a causare ansia e paura al denunciante.

Denuncia presentata in Norvegia

NOYB ha quindi presentato un reclamo al Datatilsynet norvegese. Consentendo consapevolmente al proprio modello di intelligenza artificiale di generare output diffamatori sugli utenti, OpenAI viola il principio di accuratezza dei dati ai sensi dell'articolo 5, paragrafo 1, lettera d), del GDPR. NOYB chiede a Datatilsynet di ordinare a OpenAI di rimuovere i risultati diffamatori e di perfezionare il suo modello per eliminare i risultati inesatti. Infine, NOYB suggerisce che l'autorità per la protezione dei dati imponga una multa amministrativa per prevenire violazioni simili in futuro.

NOYB, acronimo di None of Your Business, è un'organizzazione di consumatori austriaca con sede a Vienna. È stata fondata nel 2017 e si dedica alla tutela della privacy in tutta Europa.

NOYB/ gnews.cz - RoZ