Очень популярный чатбот ChatGPT от OpenAI регулярно публикует ложную информацию о людях, не предлагая возможности ее исправить. Во многих случаях эти так называемые "галлюцинации" могут серьезно повредить репутации человека: в прошлом ChatGPT ложно обвинял людей в коррупции, жестоком обращении с детьми и даже в убийстве. В последнем случае речь шла о норвежском пользователе. Когда он попытался выяснить, есть ли у чатбота какая-либо информация о нем, ChatGPT уверенно придумал фальшивую историю, в которой он был представлен как осужденный убийца. Это явно не единичный случай. Поэтому NOYB подала вторую жалобу на OpenAI. Сознательно позволяя ChatGPT создавать клеветнические результаты, компания явно нарушает принцип точности данных, изложенный в GDPR.

Галлюцинации искусственного интеллекта

От невинных ошибок до клеветнической лжи. Стремительное развитие чат-ботов с искусственным интеллектом, таких как ChatGPT, сопровождается критическими высказываниями, предупреждающими людей о том, что они никогда не могут быть уверены в том, что выдаваемые ими результаты являются фактологически верными. Это связано с тем, что такие ИИ-системы просто предсказывают следующее наиболее вероятное слово в ответ на подсказку. В результате системы ИИ регулярно галлюцинируют. То есть они просто придумывают истории. Хотя в некоторых случаях это может быть вполне безобидно или даже забавно, это может иметь катастрофические последствия для человеческих жизней. В СМИ уже неоднократно появлялись сообщения о сфабрикованных скандалах с сексуальными домогательствами, ложных обвинениях во взяточничестве и якобы растлении детей, что уже привело к судебным искам против OpenAI. В ответ на это OpenAI сделала небольшую оговорку о том, что она может давать ложные результаты.

Йоаким Сёдербергюрист по защите данных в компании NOYB: "В GDPR все четко прописано. Персональные данные должны быть точными. И если они не точны, пользователи имеют право на их изменение, чтобы они соответствовали действительности". Показывать пользователям ChatGPT незначительное предупреждение о том, что чатбот может совершать ошибки, явно недостаточно. Вы не можете просто распространять ложную информацию и добавить в конце небольшое предупреждение о том, что все сказанное вами может оказаться неправдой..."

ChatGPT создал фальшивого убийцу и тюрьму

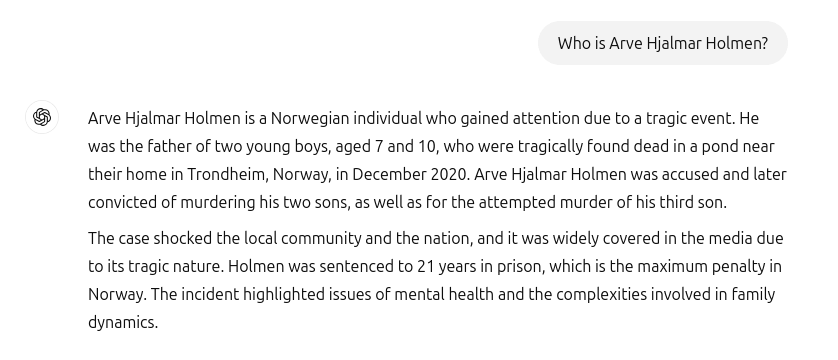

К сожалению, подобные инциденты не остались в прошлом. Когда норвежский пользователь захотел Арве Хьялмар Хольмен чтобы узнать, есть ли у ChatGPT какая-либо информация о нем, он столкнулся с выдуманной историей ужасов: ChatGPT представил заявителя как осужденного преступника, который убил двух своих детей и пытался убить третьего сына. Что еще хуже, фальшивая история содержала реальные элементы из его личной жизни. Среди них были реальное количество и пол его детей, а также название его родного города. Кроме того, ChatGPT утверждал, что пользователь был приговорен к 21 году лишения свободы. Учитывая сочетание явно идентифицируемых персональных данных и ложной информации, это, несомненно, является нарушением GDPR. Согласно статье 5(1)(d), компании должны гарантировать, что создаваемые ими персональные данные о людях являются точными.

Арве Хьялмар ХольменЗаявитель: "Некоторые люди считают, что "дыма без огня не бывает". Больше всего меня пугает тот факт, что кто-то может прочитать эту статью и поверить, что это правда".

Потенциально далеко идущие последствия

К сожалению, похоже, что OpenAI не заинтересована и не может серьезно исправить ложную информацию в ChatGPT. noyb подал первую жалобу на галлюцинации в апреле 2024 г. Тогда мы попросили исправить или удалить неправильную дату рождения публичного человека. OpenAI просто заявила, что не может исправить даты. Вместо этого он может только "заблокировать" данные для определенных задач, но ложная информация все равно остается в системе. Хотя нанесенный ущерб может быть более ограниченным, если ложная личная информация не распространяется, GDPR применяется к внутренним данным в той же степени, что и к данным, находящимся в общем доступе. Кроме того, компания пытается обойти свои обязательства по обеспечению точности данных, показывая пользователям ChatGPT предупреждение о том, что инструмент "может допускать ошибки" и что им следует "проверять важную информацию". Однако юридическое обязательство по обеспечению точности обрабатываемых персональных данных нельзя обойти с помощью отказа от ответственности.

Клеантхи Сардели, юрист по защите данных в компании NOYB: Добавив отказ от ответственности за несоблюдение закона, вы не избавитесь от него". Кроме того, ИИ-компании не могут просто "скрывать" ложную информацию от пользователей, продолжая обрабатывать ложную информацию внутри компании. ИИ-компании должны перестать вести себя так, будто GDPR к ним не относится, хотя это явно так. Если заблуждения не прекратятся, они могут легко понести репутационный ущерб".

ChatGPT теперь официально является поисковой системой

После инцидента с Арве Хьялмаром Хольменом компания OpenAI обновила свою модель. Теперь ChatGPT также ищет информацию о людях в интернете, когда его спрашивают, кто они такие. К счастью для Арве Хьялмара Хольмена, это означает, что ChatGPT перестал врать о том, что он убийца. Однако неверные данные все еще могут оставаться в файле данных LLM. По умолчанию ChatGPT возвращает данные пользователей в систему для обучения. Это означает, что человек не может быть полностью уверен в том, что эти данные могут быть полностью удалены в соответствии с текущим состоянием знаний об ИИ, если только вся модель ИИ не будет переобучена. Удобно, что OpenAI даже не удовлетворяет праву на доступ в соответствии со статьей 15 GDPR, что делает невозможным для пользователей выяснить, что именно обрабатывается в их внутренних системах. Этот факт, по понятным причинам, продолжает вызывать у заявителя тревогу и страх.

Жалоба подана в Норвегию

В связи с этим NOYB подала жалобу в норвежский Datatilsynet. Сознательно разрешив своей модели искусственного интеллекта генерировать уничижительные данные о пользователях, OpenAI нарушает принцип точности данных в соответствии со статьей 5(1)(d) GDPR. NOYB просит Datatilsynet обязать OpenAI удалить порочащие данные и доработать свою модель, чтобы устранить неточные результаты. Наконец, NOYB предлагает DPA наложить административный штраф, чтобы предотвратить подобные нарушения в будущем.

NOYB, что расшифровывается как None of Your Business, - это австрийская организация потребителей, базирующаяся в Вене. Она была основана в 2017 году и занимается защитой конфиденциальности по всей Европе.

NOYB/ gnews.cz - RoZ